Blogi AI Act -tekoälysäädös määrittää pelisäännöt tekoälyn käytölle

AI Act (Artificial intelligence act) on Euroopan Unionin tekoälysäädös, joka säätelee tekoälyn käyttöä pian täysimääräisesti EU:ssa. Komissio pyrkii saamaan käytänteet valmiiksi huhtikuuhun 2025 mennessä, ja säädöstä aletaan soveltaa vuoden 2025 loppupuolella. Tämä maailman ensimmäinen tekoälylaki tulee asettamaan pelisäännöt tekoälyteknologian kehitykselle ja soveltamiselle.

Tekoäly on vyörynyt hurjalla vauhdilla meidän kaikkien elämään. Emme olisi muutama vuosi sitten vielä osanneet kuvitellakaan muutoksen laajuutta ja varsinkaan sen nopeutta. Kyse on niin mullistavasta teknologiasta, että sen mahdollisuudet ovat lähes rajattomat, mutta samalla se tuo meidät täysin uusien eettisyys- ja turvallisuuskysymysten äärelle. Näistä syistä tekoäly tarvitsee oman lainsäädäntönsä, joka sekä edistää vastuullisen ja läpinäkyvän tekoälyn edistämistä että suojelee meitä kaikkia väärinkäytöksiltä.

Tämä ei ole ensimmäinen kerta, kun teknologinen kehitys mullistaa toimintatapojamme. Ensimmäinen digitalisaation aalto toi verkkosivut 1990-luvulla, toinen hakukoneet ja sosiaalisen median 2000-luvun puolivälissä, ja kolmas siirsi internetin taskuumme mobiiliteknologian myötä 2010-luvulla. Nyt olemme siirtyneet tekoälyn aikakauteen, jossa AI ei ole enää vain yksi teknologinen innovaatio muiden joukossa, vaan se ohjaa digitalisaation seuraavaa vaihetta.

Tekoäly on jo kaikkialla. OpenAI julkaisi ensimmäisen laajan kielimallinsa vuonna 2018, mutta varsinainen läpimurto tapahtui marraskuussa 2022, kun ChatGPT 3.5 tuli saataville. Sen jälkeen tekoälyn rooli arjessa ja liiketoiminnassa on kasvanut räjähdysmäisesti. Tämä muutos ei ole vain teknologinen, vaan myös yhteiskunnallinen ja eettinen, siksi tekoäly tarvitsee pelisäännöt. AI Act on EU:n vastaus tähän uuteen aikakauteen, ja se luo ensimmäistä kertaa maailmanlaajuisesti vaikuttavat raamit tekoälyn kehitykselle ja käytölle.

Tekoälysäädös asettaa vaatimuksia ja velvoitteita tekoälyn kehittäjille ja käyttöönottajille. Säännöt liittyvät tekoälyn käyttötarkoituksiin ja niiden tavoitteena on vähentää yrityksen hallinnollista ja taloudellista kuormaa tekoälyyn liittyen.

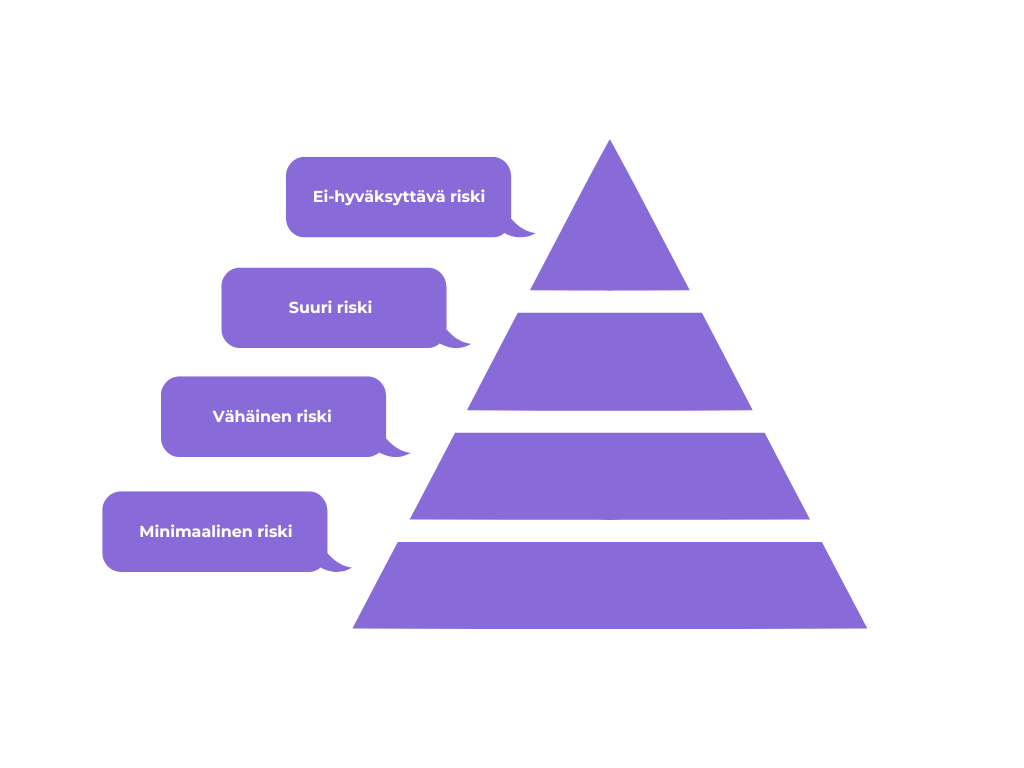

Säädös luokittelee tekoälyjärjestelmät neljään riskitasoon, joiden mukaan niille asetetaan vaatimukset:

Yleiskäyttöiset tekoälymallit, kuten ChatGPT, ovat jo osa monia järjestelmiä ja palveluita. Ne ovat tehokkaita työkaluja, mutta samalla ne voivat tuoda mukanaan riskejä. Siksi tekoälysäädös asettaa sääntöjä myös näiden mallien tarjoajille ja käyttäjille varmistaakseen, että tekoäly on turvallista ja luotettavaa käyttää. Tämä tarkoittaa muun muassa läpinäkyvyysvaatimuksia ja tekijänoikeussääntöjä, ja jos malli voi aiheuttaa merkittäviä riskejä, sen tarjoajan on myös tunnistettava ja hallittava ne. Jos yrityksesi hyödyntää ChatGPT:tä tai vastaavaa tekoälymallia osana sovelluksiaan tai palveluitaan, on tärkeää varmistaa, että käyttö on säädösten mukaista. Käyttäjille on esimerkiksi tehtävä selväksi, milloin tekoäly on mukana päätöksenteossa, ja tekijänoikeuksiin liittyvät asiat on huomioitava tarkasti.

AI Act tuo järjestystä tekoälyn kehitykseen ja käyttöön. Kun uusi tekoälyjärjestelmä on markkinoilla, vastuut jakautuvat selkeästi. Viranomaiset valvovat, että tekoäly noudattaa sääntöjä, käyttäjien tehtävänä on varmistaa, ettei järjestelmä toimi itsenäisesti ilman ihmisen valvontaa, ja tekoälyratkaisujen tarjoajien on seurattava järjestelmien toimintaa ja puututtava ongelmiin nopeasti.

Jos tekoäly aiheuttaa vakavia häiriöitä tai toimii virheellisesti, siitä on raportoitava viipymättä, jotta haitat voidaan minimoida. Lisäksi tekoälyn tuottaman sisällön on oltava tunnistettavissa, erityisesti julkiseen tiedottamiseen tarkoitetut materiaalit on merkittävä selkeästi.

Tekoäly laki tuli voimaan 1.8.2024, mutta sen soveltaminen tulee käyttöön portaittain. 2.2.2025 AI Actin ensimmäinen osa astui voimaan, ja nyt ei-hyväksyttävän riskin tekoälyjärjestelmät, kuten sosiaalinen pisteytys, on jo virallisesti kielletty EU:ssa. Yleiskäyttöisten tekoälymallien säännöt ja velvoitteet astuvat käyttöön 2.8.2025. Suuririskisillä järjestelmillä siirtymäaika kestää 2.8.207 asti.

On hyvä, että tekoälyn etiikka puhuttaa, ja saamme myös kaikille EU-maille yhteisen kehyksen ohjaamaan tekoälyn eettistä ja turvallista käyttöä. EU:lla on tavoitteena olla koko maailman turvallisen tekoälyn edelläkävijä. Kun tekoälyä säännellään ihmisoikeuksia ja perusarvoja kunnioittaen, EU:lla on mahdollisuus luoda tekoälyekosysteemi, josta hyötyvät kaikki. Tekoäly kehittyy vauhdilla, ja sen hyödyntämisessä on tärkeää pitää läpinäkyvyys ja vastuullisuus etusijalla. Jatkuva seuranta ja eettiset käytännöt varmistavat, että tekoäly toimii luotettavasti ja tuo aidosti lisäarvoa yrityksille ja yhteiskunnalle. Tekoälyn kanssa toimiminen vaatii siis jatkossa enemmän läpinäkyvyyttä, vastuullisuutta ja jatkuvaa seurantaa, mutta samalla se luo turvallisemman ja luotettavamman ympäristön tekoälyn hyödyntämiselle.

Tekoälyn eettinen käyttö puhuttaa myös meillä Hurjalla. Tästä syystä olemmekin luoneet meille omat tekoälyn eettiset periaatteet, jotka ohjaavat vastuullista käyttöä. Tekoäly voi tehostaa liiketoimintaa, sujuvoittaa prosesseja ja avata uusia mahdollisuuksia, mutta vain, kun sitä käytetään fiksusti. Hyvin hyödynnettynä se tukee parempaa päätöksentekoa, lisää tuottavuutta ja mahdollistaa entistä älykkäämmät digitaaliset palvelut.

Jos siis haluat rakentaa yritykselle tekoälyä hyödyntäviä ratkaisuja fiksusti ja vastuullisesti, jutellaan lisää!

Testaa tekoälysuosittelijaa

Pk-yritysbarometri 2025 osoittaa, että tekoäly kiinnostaa pk-yrityksiä, mutta käyttöönottoa hidastavat tieto- ja osaamisvajeet. Miten yritykset voivat kuroa eron umpeen ja hyödyntää tekoälyä tehokkaasti?

Prototypoinnissa yhdistämme asiakkaan vision, liiketoimintatavoitteet ja tekniset vaatimukset yhdeksi selkeäksi suunnaksi. Tällä matkalla tekoäly on nousemassa yhä merkittävämpään rooliin – ei korvaamaan suunnittelutyötä, vaan tukemaan sitä, erityisesti prosessin alkuvaiheissa.

Artikkelissa käymme läpi, kuinka tekoäly mullistaa teollisuuden ja miten me Hurjalla voimme auttaa yrityksiä hyödyntämään sen mahdollisuuksia.